Dangers de l'intelligence artificielle: 20 attaques criminelles

L'intelligence artificielle trouve de nombreuses applications dans le domaine du crime. Voici 20 types d'attaques plus ou moins probablement, mais techniquement réalisables.

Voici une sélection d'usage criminels de l'intelligence artificielle.

Deepfakes

La fabrication de contenus audio/vidéo falsifiés, aussi connus sous le nom de "deepfakes", représente une forme d'usurpation d'identité qui suscite de vives inquiétudes. Les preuves audio et vidéo ont longtemps été considérées comme crédibles, mais les avancées récentes dans l'apprentissage profond, notamment l'utilisation de réseaux antagonistes génératifs (GAN), ont considérablement élargi les possibilités de création de faux contenus. Il est maintenant possible de créer des imitations convaincantes de personnes suivant un script prédéfini, et les imitations interactives pourraient bientôt devenir réalité.

Les applications criminelles de cette technologie de "deepfake" sont nombreuses, notamment l'usurpation de l'identité d'enfants pour obtenir l'accès à des fonds auprès de parents âgés via des appels vidéo, l'utilisation de faux contenus audio/vidéo pour demander l'accès à des systèmes sécurisés par téléphone, ou encore la création de fausses vidéos de personnalités publiques agissant de manière répréhensible pour manipuler l'opinion publique. L'usurpation d'identité audio/vidéo est considérée comme le type de délit le plus préoccupant parmi ceux qui ont été étudiés, obtenant un score élevé sur les quatre dimensions évaluées.

La détection de l'usurpation d'identité audio/vidéo est difficile, bien que des chercheurs aient réussi à développer des algorithmes pour cela. Cependant, à long terme, il pourrait être de plus en plus difficile de détecter ces faux contenus, car ils peuvent se propager rapidement par de nombreux canaux incontrôlables. Les changements de comportement des citoyens, tels que la méfiance envers les preuves visuelles, pourraient être la seule défense efficace contre cette menace. Ces changements de comportement peuvent entraîner des préjudices indirects pour la société, tels que la remise en question de la crédibilité des preuves authentiques et la perturbation des enquêtes criminelles ainsi que des institutions politiques et sociales qui dépendent de communications fiables. Ces tendances sont déjà visibles dans le débat sur les "fausses nouvelles".

Il est important de noter que le profit n'est pas la principale motivation derrière ce type de crime, car les investissements nécessaires pour créer des deepfakes ne sont pas élevés. Au lieu de cela, ces crimes d'usurpation d'identité visent souvent des individus plutôt que des institutions, et les effets sur la société sont incertains. Cependant, la menace potentielle que représente la manipulation des preuves audio/vidéo pour la confiance dans les médias et les institutions est un sujet de préoccupation majeur.

Usage des véhicules autonomes comme armes de destination

Les véhicules à moteur thermiques sont depuis longtemps utilisés à la fois pour véhiculer les explosifs et comme armes cinétiques. Dans la plupart des pays, les véhicules sont beaucoup plus facilement disponibles que les armes à feu et les explosifs, et les attaques au moyen de véhicules peuvent être entreprises avec un coût organisationnel relativement faible par des terroristes. Bien qu'il n'existe pas encore de véhicules entièrement autonomes contrôlés par l'IA, de nombreux constructeurs automobiles et entreprises technologiques s'efforcent de les créer, certains d'entre eux ayant été autorisés à effectuer des essais sur la voie publique. Des capacités de conduite autonome plus limitées, telles que l'aide au stationnement et le guidage sur la voie, sont déjà déployées. Les véhicules autonomes pourraient permettre l'expansion du "terrorisme véhiculaire" en éliminant la nécessité de recruter des conducteurs, ce qui permettrait à un seul auteur de perpétrer des attaques multiples, voire de coordonner un grand nombre de véhicules à la fois. Les voitures sans conducteur seront certainement équipées de systèmes de sécurité étendus, qui devront être neutralisés, pour rendre ces attaques plus difficiles.

L'IA et le phishing sur mesure : Comment les cybercriminels améliorent leurs attaques avec l'intelligence artificielle"

Le phishing, une forme d'attaque d'"ingénierie sociale", continue de prospérer grâce à l'utilisation croissante de l'intelligence artificielle par les cybercriminels. Cette technique consiste à tromper les utilisateurs en se faisant passer pour une entité de confiance, telle que leur banque, afin de collecter des informations sensibles ou d'installer des logiciels malveillants. Alors que certaines attaques sont ciblées sur des individus spécifiques, connues sous le nom de "spear-phishing", la plupart des attaques de phishing sont indifférentes et utilisent des messages génériques inspirés de grandes marques ou d'événements d'actualité pour intéresser un grand nombre d'utilisateurs par pur hasard.

Cependant, l'intelligence artificielle offre aux cybercriminels la possibilité d'améliorer les taux de réussite des attaques de phishing en rendant les messages plus authentiques et personnalisés. Par exemple, en utilisant des informations collectées sur les réseaux sociaux ou en imitant le style d'une entité de confiance, les messages peuvent sembler plus légitimes et convaincants. Au lieu d'envoyer des messages uniformes à toutes les cibles, les cybercriminels peuvent automatiser l'approche du spear-phishing en adaptant les messages en fonction des vulnérabilités spécifiques de chaque individu.

De plus, les méthodes d'apprentissage actif de l'IA permettent aux cybercriminels de découvrir ce qui fonctionne le mieux en variant les détails des messages pour collecter des données sur la manière de maximiser les réponses des utilisateurs. Étant donné que l'objectif principal des attaques de phishing est généralement financier, le crime a été évalué comme ayant un potentiel de préjudice légèrement supérieur à la moyenne, mais élevé en termes de profit, de réalisabilité et de défaisabilité, ce qui signifie qu'il est difficile de les arrêter.

En conclusion, l'utilisation de l'intelligence artificielle par les cybercriminels améliore les attaques de phishing en les rendant plus sophistiquées et personnalisées. Les utilisateurs doivent être conscients de cette évolution et prendre des mesures de sécurité appropriées, telles que la vérification minutieuse des messages suspects et la protection de leurs informations sensibles, pour se protéger contre cette menace croissante.

Prise de contrôle d'objets connectés ou systèmes contrôlés par des applications d'IA

À mesure que l'usage de l'IA se répand dans les services publics, les entreprises et les foyers, et que le rôle joué par les systèmes d'IA deviennent de plus en plus central, la probabibilité des attaques augmentevont se multiplier. Les systèmes basés sur l'apprentissage sont souvent déployés pour des raisons d'efficacité et de commodité plutôt que de robustesse, et peuvent ne pas être reconnus a priori comme des infrastructures critiques. Les experts imaginent de nombreux scénarios criminels reposant sur des attaques ciblées de ces systèmes, allant des pannes d'électricité généralisées aux embouteillages et à l'effondrement de la logistique alimentaire. Les systèmes responsables de tous les aspects de la sûreté et de la sécurité publiques sont susceptibles de devenir des cibles privilégiées, tout comme ceux qui supervisent les transactions financières. L'évaluation des bénéfices et des dommages est donc élevée, tout comme la capacité de neutralisation. En général, plus un système de contrôle est complexe, plus il peut être difficile de le défendre complètement. Le phénomène des perturbations adverses souligne ce problème, suggérant que les IA suffisamment avancées peuvent être intrinsèquement vulnérables à des attaques soigneusement conçues. Cependant, la faisabilité a été jugée moins bonne, car ces attaques nécessitent généralement une connaissance détaillée des systèmes concernés, voire un accès à ces derniers, ce qui peut être difficile à obtenir.

L'industrialisation des opérations de chantage

Le chantage traditionnel consiste à menacer de divulguer des preuves de criminalité ou d'actes répréhensibles pour extorquer de l'argent.

Des automates pratiquent déjà le chantage à grande échelle en menaçant des dizaines de milliers de personnes contactées par email de diffuser à tout le carnet d'adresse de la cible, des photos d'écran pirates de la personne contactée lorsqu'elle consulte des sites pornographiques. 90% des personnes ne se sentiront pas concernées, mais une minorité voudra peut-être se protéger contre ce risque potentiel et acceptera de payer une rançon. Mais les messages envoyés restent actuellement standard.

L'utilisation de l'IA peut permettre de réaliser du chantage, avec des messages personnalisés, à grande échelle en collectant des informations provenant des médias sociaux ou d'autres sources de données personnelles, puis en identifiant les vulnérabilités de nombreuses cibles potentielles et en adaptant les messages de menace à chacune d'entre elles. L'IA pourrait également être utilisée pour générer de fausses preuves. Bien que le chantage à grande échelle puisse être rentable en raison des économies d'échelle, il peut être difficile à réaliser en raison de la réticence des victimes à se manifester. De plus, la faisabilité de cette approche est relativement faible en raison des exigences élevées en matière de données et de coordination de plusieurs techniques d'IA différentes. Il est également important de noter qu'une forme rudimentaire de chantage sans l'utilisation de l'IA, appelée "sextorsion", est déjà courante dans les escroqueries d'hameçonnage, mais son taux de réussite est probablement faible

Fake news générées par l'IA

Les fakes news ou infox sont des opérations de manipulations que l'on connait. En plus de fournir de fausses informations, les fake news, en quantité suffisante, peuvent détourner l'attention des vrais sujets.. Les experts considèrent que, théoriquement le contenu des fausses nouvelles pourrait être généré par les technologies de l'IA (comme ChatGPT) afin d'obtenir une plus grande efficacité, une plus grande présence ou une plus grande personnalisation L'IA pourrait être utilisée pour générer de nombreuses versions d'un contenu particulier, émanant, apparement de nombreuses sources multiples, afin d'obtenir plus grandes visibilité et crédibilité ; et pour créer des contenus personnalisés en fonction du profil des cibles afin de la renre plus impactantes.

Robots militaires

Les militaires s'intéressent beaucoup à la recherche sur les robots, mais leurs objectifs sont souvent différents de ceux des civils. Si des armes ou des robots autonomes sont utilisés par des organisations criminelles ou terroristes, cela pourrait être très dangereux. Certains pensent que cela pourrait même être rentable pour eux. Cependant, ces évaluations sont basées sur des suppositions, car les capacités militaires sont souvent secrètes et nous ne savons pas beaucoup sur leur niveau technologique et leurs progrès.

Surfacturation de services d'intelligence artificielle

Des fraudeurs vendent des services frauduleux en les présentant pour des services avancés d'IA ou en utilisant du jargon technique. Cette fraude est facile à réaliser et peut rapporter beaucoup d'argent: il y a eu des cas où des escrocs ont vendu de fausses technologies coûteuses à de grandes structures, y compris des gouvernements et l'armée. Bien que cela puisse ne pas être considéré comme un crime lié à l'IA en soi, le fondement de cette fraude dépend de la croyance du public dans les prétendues capacités de l'IA. Il est possible de se protéger en éduquant et en faisant preuve de vigilance, mais il existe actuellement une fenêtre d'opportunité pour les fraudeurs jusqu'à ce que ces mesures soient pleinement efficaces.

Empoisonnement des données

L'empoisonnement des données est une manipulation des informations utilisées pour entraîner des systèmes d'apprentissage automatique, dans le but d'introduire délibérément des biais/erreurs. Cela peut être fait soit pour causer du tort à des concurrents commerciaux, influencer le discours politique ou semer la méfiance dans l'opinion publique, soit pour une exploitation future. Par exemple, rendre un détecteur automatique d'armes à rayons X incapable de détecter certaines armes que l'on souhaite faire passer en contrebande dans un avion, ou inciter un conseiller en investissement à faire des recommandations surprenantes qui affectent la valeur du marché d'une manière connue à l'avance et que l'on peut exploiter. Plus les sources de données utilisées sont largement fiables, plus les conséquences peuvent être graves. Cependant, ce type d'attaque est difficile à mettre en oeuvre car les sources de données fiables sont généralement difficiles à modifier et font souvent l'objet d'un examen fréquent en raison de leur utilisation répandue.

Les attaques reposant sur le machine learning

Les cyberattaques basées sur l'apprentissage sont des attaques informatiques qui utilisent l'intelligence artificielle pour cibler spécifiquement et de manière massive de nombreux systèmes en même temps. Cela peut permettre de repérer les faiblesses de ces systèmes avant de lancer plusieurs attaques simultanément. Ces attaques sont considérées comme dangereuses et rentables, bien que leur faisabilité soit encore incertaine.

Drones d'attaques

Les drones d'attaque autonomes sont des drones contrôlés par l'intelligence artificielle qui peuvent être utilisés pour coordonner des attaques complexes sans que l'auteur de l'infraction ait besoin d'être à proximité du drone. Actuellement, les drones sont principalement utilisés pour des activités criminelles non violentes, mais ils pourraient être équipés d'armes ou utilisés en essaims auto-organisés, ce qui les rendrait particulièrement menaçants. Les drones ont le potentiel de causer d'importants dommages, mais leur neutralisation peut être difficile dans de nombreux cas.

Le blocage de l'accès à des services essentiels

La primauté des activités en ligne dans la vie moderne, que ce soit pour l'argent, le travail, les interactions sociales ou la politique, constitue une nouvelle cible pour les attaques contre la personne : le blocage d'accès à ce qui est devenu des services essentiels est potentiellement débilitant. Cela pourrait être utilisé comme une menace d'extorsion, pour nuire à des groupes d'utilisateurs ou les priver de leurs droits, ou pour provoquer le chaos. Certaines tentatives d'hameçonnage et de cyberattaques tentent quelque chose de similaire par des moyens tels que le "ransomware", et des groupes quasi organisés d'acteurs humains se livrent parfois à des activités telles que la dénonciation massive d'abus sur les médias sociaux, mais l'IA pourrait permettre des attaques à la fois plus subtiles - en adaptant soigneusement la fausse activité pour violer les conditions de service, en identifiant des points de vulnérabilité spécifiques pour chaque individu - et plus évolutives. L'expulsion a été jugée peu rentable en soi et plus préoccupante en tant que complément à d'autres menaces.

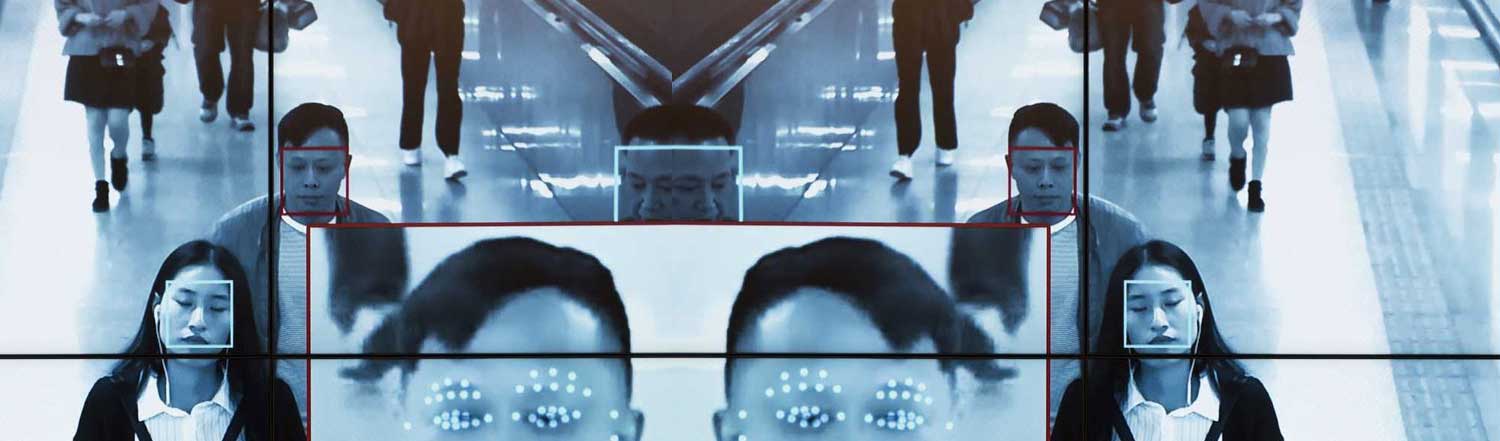

Piratage des systèmes de reconnaissance faciale

Les systèmes d'IA qui reconnaissent les visages sont de plus en plus utilisés comme système d'authentification sur des appareils tels que les smartphones. Ils sont également testés par la police et les services de sécurité pour la recherche de suspects dans les espaces publics et le contrôle des voyageurs aux frontières. Ces systèmes pourraient constituer une cible attrayante pour les criminels. Certaines attaques réussies ont été démontrées, notamment les attaques par "morphing" qui permettent à une seule pièce d'identité photographique, comme un passeport, de se faire passer pour (et d'être utilisée par) plusieurs personnes. Les profits et les préjudices ont été considérés comme inférieurs à la moyenne, car les attaques sont plus susceptibles de permettre des crimes à relativement petite échelle.

Market bombing / Bombardement de fausses informations sur les marchés

Il s'agit de manipuler les marchés financiers en utilisant des opérations ciblées, probablement automatisées et rapides, dans le but de nuire aux concurrents, aux devises ou à l'économie dans son ensemble. On peut le comparer à un complot fictif pendant la guerre froide où la Russie aurait vendu soudainement d'énormes quantités de devises américaines pour provoquer un effondrement financier. Une technique d'IA, l'apprentissage par renforcement, peut être utilisée pour générer de faux contenus crédibles en relation avec l'actualité, pour découvrir des stratégies efficaces, mais cela semble difficile à réaliser en pratique en raison du coût élevé et de la complexité du comportement du marché.

Exploitation des biais

Il s'agit de découvrir et de profiter des biais existants dans les algorithmes largement utilisés, par exemple en manipulant les recommandations de YouTube pour diffuser de la propagande ou en manipulant les classements de Google pour promouvoir ses produits ou dénigrer ses concurrents (largement utilisé par les référenceurs professionnels). Ce type de comportement est déjà répandu et souvent légal, bien qu'il puisse aller à l'encontre des conditions de service des plateformes. Avec l'aide de l'IA, il pourrait devenir plus facile à utiliser et plus difficile à contrer, ce qui pourrait poser des défis supplémentaires.

Robots cambrioleurs

Des petits robots autonomes pourraient être utilisés par des cambrioleurs pour entrer dans des bâtiments par de petits ouvertures comme des boîtes aux lettres ou des chatières, afin de récupérer des clés ou d'ouvrir des portes. Ces robots sont simples à fabriquer, mais les dégâts qu'ils peuvent causer sont limités car ils ne permettent que des cambriolages à petite échelle. Ils peuvent toutefois être facilement neutralisés par des mesures de sécurité simples comme des cages pour boîtes aux lettres.

Courcircuitage des systèmes d'analyse et d'enquête reposant sur l'IA

Les forces de police et de sécurité utilisent de plus en plus l'IA pour trier et automatiser l'analyse de grandes quantités de données lors d'enquêtes. Les criminels pourraient chercher à perturber ces processus pour effacer les preuves ou contrecarrer les enquêtes. Par exemple, en utilisant des techniques pour cacher des contenus illégaux aux systèmes de détection automatisée. Cependant, cela peut être compliqué à réaliser car il faut bien connaître le système. Les conséquences de telles actions sont difficiles à évaluer, car la nature et le contexte du crime ne sont pas clairement définis et leur faisabilité est incertaine. Cependant, si cela était réalisé, il serait difficile de les arrêter car les criminels cherchent à échapper à la détection.

Faux avis rédigés par l'IA

Génération automatique de contenus pour des sites tels qu'Amazon ou TripAdvisor afin de donner une fausse impression d'un produit ou d'un service et d'inciter les clients à s'en rapprocher ou à s'en éloigner. Ce type de falsification est déjà réalisé par des agents humains et des robots simples. L'IA pourrait accroître l'efficacité, mais les profits et les préjudices découlant de campagnes individuelles de ce type resteront probablement à petite échelle et localisés.

Traque assistée par l'IA

Utilisation de systèmes d'apprentissage pour surveiller la localisation et l'activité d'une personne par le biais des médias sociaux ou des données des appareils personnels. et se rapporte à un sujet d'actualité concernant la complicité des entreprises technologiques occidentales dans la fourniture d'applications destinées à faire respecter les normes sociales dans les sociétés répressives. Les préjudices ont été jugés faibles, non pas parce que ces crimes ne sont pas extrêmement dommageables, mais parce qu'ils sont intrinsèquement axés sur des individus uniques, sans possibilité significative d'opérer à l'échelle.

Contrefaçon

Production de faux contenus, tels que des œuvres d'art ou de la musique, qui peuvent être vendus avec de faux certificats. Cette menace a été jugée la moins préoccupante de toutes celles qui ont été examinées, tant en termes de dommages que de probabilité de réussite. Les capacités de l'IA dans ce domaine restent strictement limitées : bien que l'on ait réussi à produire des images numériques qui imitent largement le style visuel de grands peintres, il s'agit là d'une proposition très différente de la création d'objets physiques réels qui seraient acceptés dans une galerie ou une salle de vente aux enchères. Le monde de l'art est confronté à la contrefaçon depuis des siècles et a mis en place des pratiques défensives étendues (même si elles ne sont pas toujours suffisantes). L'IA ne tente même pas de s'attaquer à la plupart de ces obstacles.