Sommet Mondial de l'IA 2025 à Paris. Expérience de prédiction

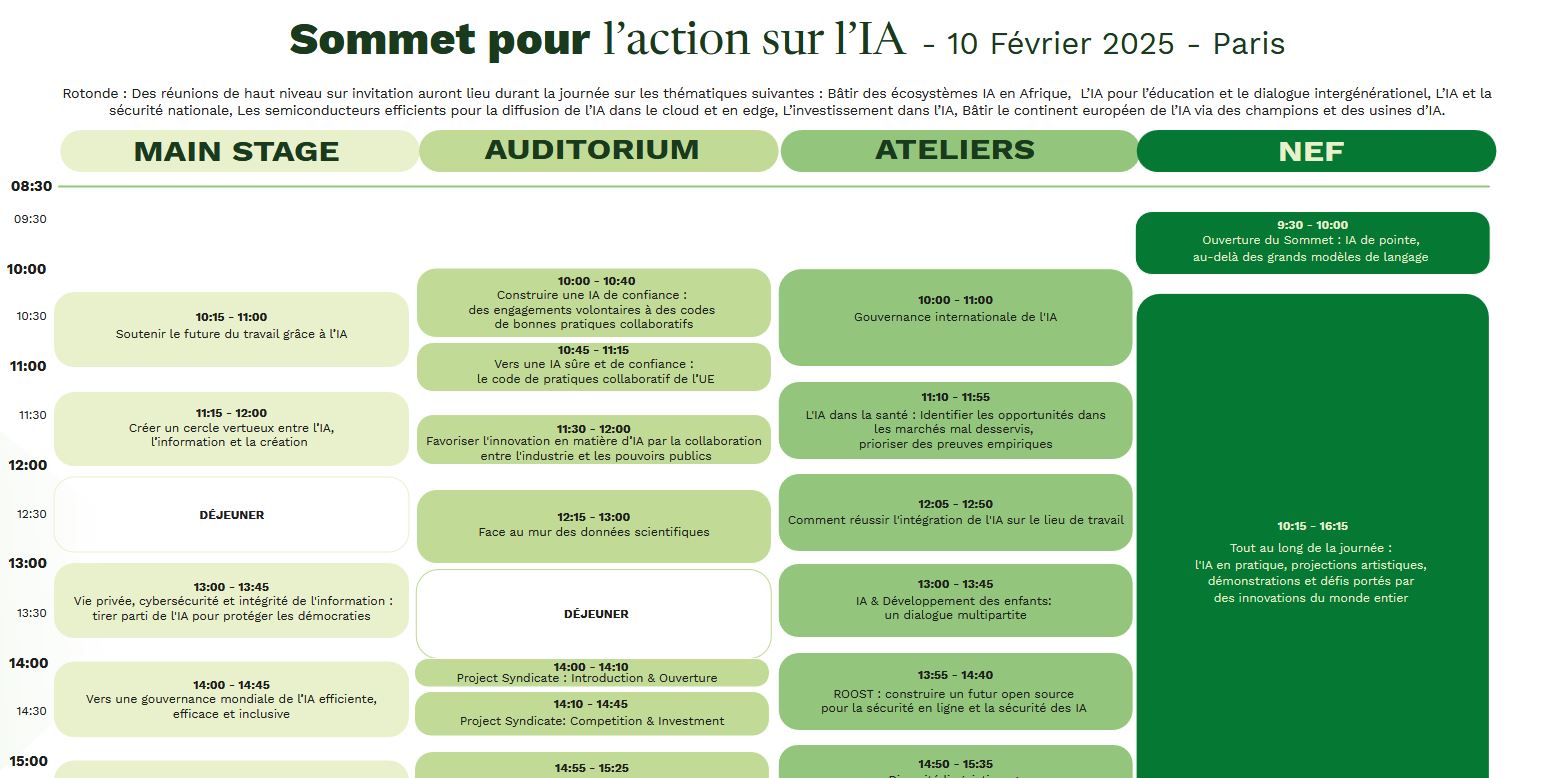

Vous n'avez pas la chance d'assister au sommet mondial de l'IA organisé à Station F les 10 et 11 février 2025, voici le résumé de ce qui sera échangé, enfin....selon ChatGPT !

Le Sommet Mondial de l'IA est réservé à 1500 personnes triées sur le volet: officiels, chercheurs, eprésentant d'association, journalistes de grand média, start-up médiatisées...

C'est un événement avant tout dédié à la communication et à l'émergence de collaborations inter gouvernementales.

C'est un peu comme les COP climat ou biodiversité.

Si vous auriez aimé assisté à cet événement, vous pouvez vous connecter à la chaîne Youtube du somme qui retransmet le live une partie des interventions (conférences plénières, tables rondes atelier).

Je l'ai fait pour deux tables rondes et le contenu était un peu ... convenu, mais aussi parfois sophorifiques (les fonctionnaires européens ou chefs d'état africains qui ont été invités pour parler ne sont pas forcément les mieux informés sur l'IA).

Du coup, comme le contenu des interventions était assez "convenu" comme je le disais, j'ai eu l'idée de demander à ChatGPT de rédiger le texte des interventions des conférenciers, des questions et réponses des tables rondes et le contenu des ateliers.

Je mise sur le fait que cela sera plus digeste, moins long et assez proche de ce qui sera échangé.

Ensuite, si j'ai le temps, je demanderai à Mistral de résumer le transcript Youtube de ces interventions. Nous pourrons alors comparer les versions imaginées par ChatGPT et ce qui aura été réellement dit durant les conférences.

J'ai créé un GPT que j'ai spécialisé pour qu'il imagine ce qui sera dit dans les conférences, dans les tables rondes et ateliers, uniquement à partir de leur intitulé.

Tout ce qui suit a été imaginé par un LLM: le fonds, la forme, les noms des intervenants. Il ne s'agit pas de ce qui a été dit ou sera dit durant le sommet mondial de l'IA à Paris le 10 février 2025.

Si, par hasard, ce contenu était proche du contenu réellement échangé par les véritables intervenants, il ne s'agirait pas d'une coïncidence, mais cela signifierait que les intervenants se sont contentés de relayer le conscencus mondial autour de l'IA.

Conférence : Soutenir le futur du travail grâce à l’IA (Contenu généré et imaginé par ChatGPT)

Intervenant : Dr. Claire Morel, Directrice de la Recherche en Intelligence Artificielle chez Mistral AI

Introduction

Mesdames et Messieurs, bonjour. C'est un honneur d'être ici aujourd'hui pour discuter d'un sujet essentiel : comment l'intelligence artificielle peut soutenir et façonner le futur du travail. Loin d'être une menace pour l'emploi, l'IA peut être une force transformatrice qui améliore la productivité, la qualité de vie au travail et l'inclusion professionnelle.

Les enjeux économiques et sociétaux :

L'automatisation et l'IA soulèvent de nombreuses questions :

- Comment répartir équitablement les gains de productivité qu'elles génèrent ?

- Comment éviter une polarisation excessive du marché du travail entre emplois hautement qualifiés et emplois précaires ?

- Comment repenser les modèles d'organisation du travail pour intégrer l'IA de manière éthique et efficace ?

L'impact de l'IA varie selon les secteurs. Certains emplois vont évoluer, d'autres disparaître, mais surtout, de nouvelles opportunités vont apparaître. L'accompagnement des travailleurs dans cette transition est crucial.

Perspectives et usages :

Les entreprises utilisent déjà l'IA pour améliorer la productivité et optimiser leurs processus. Quelques exemples concrets :

- Automatisation des tâches répétitives : l'IA permet de décharger les employés des activités routinières, leur laissant plus de temps pour des missions à plus forte valeur ajoutée.

- Amélioration de la prise de décision : grâce à l'analyse avancée des données, les entreprises peuvent anticiper les tendances et adapter leurs stratégies.

- Formation et reskilling : des outils basés sur l'IA personnalisent les parcours d'apprentissage et facilitent l'adaptation des compétences aux besoins du marché.

Problèmes et solutions :

Toutefois, plusieurs défis subsistent :

- L'impact sur l'emploi : comment assurer une transition douce pour les travailleurs dont les emplois sont automatisés ?

*Solution* : Mettre en place des programmes de formation et de reconversion accessibles à tous.

- L'éthique de l'IA au travail : comment éviter la discrimination algorithmique et garantir une IA responsable ?

*Solution* : Adopter des régulations transparentes et impliquer les partenaires sociaux dans la gouvernance de l'IA.

- Le bien-être des travailleurs : comment prévenir le stress et l'isolement causés par la transformation numérique ?

*Solution* : Promouvoir des modes de travail hybrides et veiller à une intégration harmonieuse de l'IA dans les tâches humaines.

Conclusion :

L'IA n'est ni une menace, ni une panacée : c'est un outil puissant qui, bien utilisé, peut améliorer les conditions de travail et développer de nouvelles opportunités économiques. Mais cela nécessite un effort collectif, impliquant gouvernements, entreprises et travailleurs. La clé réside dans la formation continue, l'éthique et une approche centrée sur l'humain.

Merci de votre attention.

Voici maintenant la retranscription de l'intervention des véritables intervenants.

Ce changement positif que l'on appelle de nouveau, sans plus attendre, je propose que l'on démarre et que l'on fasse un pas vers l'avenir, vers l'IA. Notre première session, intitulée "Mettre l'IA au service de l'avenir du travail", parlera de comment nos sociétés et le monde du travail vont être refaçonnés par l'IA. L'IA est synonyme d'opportunités, de création de nouveaux emplois, de nouvelles perspectives, mais aussi, évidemment, de défis à surmonter. Par exemple, la qualité de l'emploi et l'écart que l'IA pourrait creuser entre les uns et les autres. Nous allons donc nous intéresser à la manière dont l'IA peut être une solution à tout cela.

Nous avons S. Coursel pour modérer cet échange, et je vous invite à l'applaudir chaleureusement.

Mesdames et messieurs, bienvenue à cette discussion de haut niveau sur l'IA et comment la mettre au service de l'avenir du travail. L'IA est en train de transformer nos sociétés et nos économies à une très grande vitesse. Elle apporte son lot d'opportunités et de défis. Il faut qu'il y ait une trajectoire partagée par tous pour que l'IA soit mise au service du travail, qu'elle ne soit pas une transition comme les autres, mais bien un enjeu politique. C'est un enjeu politique dans la mesure où nous devons faire des choix stratégiques sur l'avenir que nous voulons ensemble. Les entreprises, les partenaires sociaux, les organisations internationales sont mobilisés afin de concrétiser la mise en œuvre de l'IA dans le contexte du travail.

Aujourd'hui, c'est un honneur d'avoir ici des leaders qui vont partager avec nous leurs éclairages sur toutes ces questions. Je vais maintenant les présenter. Nous avons Monseigneur Paul Taille, qui travaille pour l'éducation et la culture. Nous avons aussi Gilbert Fosser, directeur général de l'OIT, ainsi que Christy Hoffman, secrétaire générale de UNI Global Union. Également présents, Denis Machel, président-directeur général d'un grand groupe, et Guillaume, PDG d'Airbus.

Je vais commencer avec vous, Monsieur Fosser. En tant que directeur général de l'OIT, la question que j'aimerais vous poser est la suivante : comment pensez-vous que l'IA va bouleverser le monde du travail ?

Bonjour à toutes et à tous, merci beaucoup. L'IA va avoir un impact sur le monde du travail. C'est quelque chose dont on parle depuis un certain temps, et surtout, c'est une transformation qui est déjà en cours. Contrairement à ce que l'on pourrait imaginer, du côté de l'OIT, nos travaux nous montrent qu'il n'y a pas de quoi s'inquiéter outre mesure. Il n'y aura pas un remplacement massif ni une perte d'emplois généralisée. Toutefois, des millions d'emplois vont être transformés, certains disparaîtront, mais d'autres seront créés.

Pour l'instant, l'écart que nous observons entre les emplois détruits et ceux créés est à l'avantage de la création d'emplois. Notre objectif est donc d'accompagner cette transition, de veiller à ce que les travailleurs soient formés aux nouvelles compétences et que l'IA ne soit pas un facteur d'exclusion, mais bien un levier d'inclusion.

La question de la régulation est également essentielle. Nous devons nous assurer que les avancées technologiques ne profitent pas uniquement à une minorité, mais qu'elles soient accessibles à l'ensemble des travailleurs et des entreprises. Il faut également encadrer l'utilisation de l'IA pour garantir le respect des droits des travailleurs, la protection sociale et l'éthique dans le développement de ces outils.

J'aimerais maintenant entendre Christy Hoffman sur cette question. En tant que secrétaire générale d'UNI Global Union, comment percevez-vous l'impact de l'IA sur les travailleurs et quels sont les défis majeurs à relever selon vous ?

Merci beaucoup. L'IA représente à la fois une opportunité et un défi considérable pour les travailleurs. D'un côté, elle permet d'automatiser des tâches répétitives et de créer de nouveaux métiers, mais de l'autre, elle soulève des préoccupations importantes en matière de droits des travailleurs, de précarisation de l'emploi et de surveillance accrue dans le milieu professionnel. Ce que nous observons déjà aujourd'hui, c'est que l'IA est utilisée dans certains secteurs pour surveiller la productivité des employés, parfois de manière intrusive, voire abusive.

Il est impératif que nous mettions en place des cadres réglementaires robustes pour éviter ces dérives. Les travailleurs doivent être associés aux décisions concernant l'intégration de l'IA dans leur environnement de travail. Cela passe par des négociations collectives, des discussions ouvertes avec les employeurs et la mise en place de garde-fous législatifs.

L'autre point crucial est la formation. De nombreux travailleurs ne sont pas encore équipés pour s'adapter aux transformations induites par l'IA. Il est donc primordial d'investir massivement dans la formation continue et l'acquisition de nouvelles compétences. Les gouvernements, les entreprises et les syndicats doivent travailler main dans la main pour garantir une transition juste.

Je vais continuer la retranscription du texte en supprimant les timecodes et en reformulant pour une meilleure lisibilité. Voici la suite :

Denis Machel, en tant que PDG d’un grand groupe, quel est votre regard sur cette transition vers un monde du travail transformé par l’IA ?

Merci. Du point de vue des entreprises, l’IA est une formidable opportunité, mais elle implique une grande responsabilité. Nous avons un devoir envers nos collaborateurs : leur permettre de s’adapter et de tirer parti de cette révolution technologique. Contrairement à certaines craintes, nous ne pensons pas que l’IA remplacera massivement les emplois existants. En revanche, elle modifie profondément la nature des compétences requises.

Notre rôle, en tant que dirigeants, est d’anticiper ces changements et d’accompagner nos employés pour qu’ils puissent évoluer avec les technologies. Cela passe par des formations, la mise en place d’une culture d’innovation et un dialogue constant entre toutes les parties prenantes. L’IA ne doit pas être une source d’exclusion, mais un levier d’inclusion et d’amélioration des conditions de travail.

Par exemple, dans notre entreprise, nous avons intégré des outils d’IA pour automatiser certaines tâches administratives répétitives. Cela permet à nos employés de se concentrer sur des missions à plus forte valeur ajoutée. Cependant, nous sommes aussi conscients des risques, notamment en matière de confidentialité des données et d’équilibre entre automatisation et maintien de l’emploi.

Guillaume, en tant que PDG d’Airbus, quel est votre point de vue sur l’utilisation de l’IA dans votre secteur ?

L’IA joue un rôle clé dans l’industrie aéronautique. Elle est utilisée pour optimiser la maintenance des avions, améliorer la sécurité des vols et rendre la production plus efficace. Grâce aux algorithmes d’apprentissage automatique, nous pouvons anticiper les pannes avant qu’elles ne surviennent, ce qui réduit les coûts et améliore la fiabilité des appareils.

Mais l’IA ne se limite pas à la technique. Elle transforme également nos méthodes de travail. Nous avons, par exemple, mis en place des assistants virtuels pour aider nos ingénieurs et techniciens dans leur quotidien. Cela permet d’accélérer les processus et de garantir une meilleure prise de décision.

Un autre aspect important est la formation des employés. Il est essentiel que les professionnels de l’aéronautique comprennent comment utiliser ces outils et en tirer le meilleur parti. Pour cela, nous investissons dans des programmes éducatifs et collaborons avec des institutions académiques afin d’adapter les cursus aux nouvelles exigences du secteur.

L’IA ne doit pas être perçue comme une menace, mais comme un atout. Toutefois, nous devons nous assurer que son intégration se fasse de manière éthique et responsable.

Revenons maintenant à la dimension réglementaire et sociale. Monsieur Fosser, comment les instances internationales travaillent-elles pour encadrer l’IA dans le monde du travail ?

C’est une question essentielle. L’Organisation Internationale du Travail s’efforce d’élaborer des lignes directrices pour une adoption responsable de l’IA. Nous travaillons en étroite collaboration avec les gouvernements, les entreprises et les syndicats pour définir des normes adaptées.

L’une de nos priorités est d’assurer une transition équitable. Nous savons que certains secteurs seront plus impactés que d’autres. Il est donc fondamental de mettre en place des mesures d’accompagnement pour les travailleurs concernés. Cela passe par des politiques de reconversion professionnelle, des mécanismes de protection sociale et des cadres réglementaires garantissant le respect des droits fondamentaux.

Nous mettons également l’accent sur la transparence des algorithmes et la protection des données. Les entreprises doivent être tenues responsables de l’utilisation qu’elles font de l’IA, et les travailleurs doivent avoir un droit de regard sur les décisions automatisées qui les concernent.

Enfin, nous encourageons les États à investir dans l’éducation et la formation. Il est impératif que les compétences numériques soient intégrées dès le plus jeune âge et que les travailleurs puissent se former tout au long de leur carrière.

Christy Hoffman, que pensez-vous des propositions de régulation en cours ?

Nous saluons les efforts déployés pour encadrer l’IA, mais nous pensons qu’il faut aller encore plus loin. Le principal enjeu est de garantir que ces technologies ne soient pas utilisées au détriment des travailleurs. Par exemple, certaines entreprises utilisent l’IA pour surveiller les performances de leurs employés en temps réel, ce qui peut générer une pression excessive et une détérioration des conditions de travail.

Nous demandons donc des règles claires pour limiter ces abus. Les travailleurs doivent avoir un droit à la déconnexion, et les décisions automatisées doivent pouvoir être contestées. De plus, nous plaidons pour une plus grande implication des syndicats dans les discussions autour de l’IA. Ce n’est qu’en incluant toutes les parties prenantes que nous pourrons construire un modèle équilibré et bénéfique pour tous.

Enfin, nous devons nous attaquer à la question des inégalités. L’IA risque d’accroître le fossé entre les travailleurs hautement qualifiés et ceux qui exercent des métiers plus vulnérables à l’automatisation. Il est donc crucial de mettre en place des mécanismes de redistribution et des programmes de formation accessibles à tous.

Voici la suite du texte reconstitué :

- Coursel : Merci pour ces précisions. Nous voyons bien que la transformation du travail par l’IA soulève des questions fondamentales d’équilibre entre innovation et préservation des droits. Avant de poursuivre avec les autres intervenants, j’aimerais ouvrir le débat sur un point central : la formation et l’adaptation des compétences. Comment s’assurer que les travailleurs, à tous les niveaux, puissent bénéficier de cette révolution et non en être victimes ?

Denis Machel : C’est une question clé. La formation doit être au cœur des stratégies des entreprises et des gouvernements. Il ne suffit pas de former les nouvelles générations, il faut aussi accompagner ceux qui sont déjà en poste. Nous avons mis en place un programme de formation continue pour permettre à nos employés d’acquérir des compétences numériques et de se familiariser avec les outils d’IA.

Nous avons constaté que lorsque les travailleurs comprennent les bénéfices de l’IA, ils l’adoptent plus facilement et en font un allié dans leur quotidien. Le défi est donc autant technologique que pédagogique. Il faut démystifier l’IA, expliquer ses limites et permettre à chacun de trouver sa place dans ce nouvel écosystème.

Guillaume : J’aimerais ajouter que la formation ne doit pas seulement être une adaptation aux besoins immédiats des entreprises. Elle doit aussi donner aux travailleurs la capacité d’évoluer sur le long terme. L’IA évolue rapidement, et les compétences nécessaires aujourd’hui ne seront pas forcément les mêmes demain. C’est pourquoi nous devons encourager la formation continue, l’apprentissage tout au long de la vie et la reconversion professionnelle.

Nous travaillons par exemple avec des universités et des instituts de recherche pour anticiper les métiers de demain et adapter les cursus en conséquence. Il faut aussi renforcer les partenariats entre les entreprises et les établissements d’enseignement, afin que les formations correspondent réellement aux besoins du marché.

- Coursel : Une autre question importante concerne l’impact de l’IA sur les conditions de travail. On parle beaucoup de gains de productivité, mais aussi de risques accrus en termes de surveillance et de pression sur les travailleurs. Christy Hoffman, avez-vous des exemples concrets de ces dérives ?

Christy Hoffman : Oui, malheureusement. Nous avons observé que dans certains secteurs, notamment la logistique et les services, l’IA est utilisée pour surveiller en permanence les performances des employés. Par exemple, dans certains entrepôts, des algorithmes calculent le temps que met un employé à accomplir une tâche et génèrent automatiquement des alertes s’il est jugé trop lent. Cela crée une pression énorme et une déshumanisation du travail.

Un autre problème est la prise de décision automatisée en matière de recrutement et de gestion des ressources humaines. Certains logiciels d’IA évaluent les candidatures sur la base de critères opaques, ce qui peut conduire à des discriminations involontaires. Nous devons exiger plus de transparence et garantir que ces outils soient utilisés de manière éthique.

- Coursel : Monsieur Fosser, comment l’OIT aborde-t-elle ces enjeux ?

Gilbert Fosser : Nous travaillons sur plusieurs axes. Tout d’abord, nous recommandons aux gouvernements et aux entreprises de mettre en place des garde-fous pour éviter les abus. L’IA ne doit pas être un instrument de surveillance généralisée, mais un outil d’amélioration des conditions de travail. Il est essentiel que les employés aient un droit de regard sur la manière dont ces technologies sont utilisées.

Nous plaidons également pour une régulation internationale de l’IA dans le monde du travail. Il faut des normes claires et des mécanismes de contrôle pour s’assurer que ces outils sont utilisés de manière responsable. Nous encourageons les pays à adopter des législations qui protègent les travailleurs et à promouvoir un dialogue social autour de ces questions.

- Coursel : Nous avons beaucoup parlé des risques, mais revenons aussi sur les opportunités. Quels sont, selon vous, les bénéfices les plus concrets que l’IA peut apporter au monde du travail ?

Denis Machel : L’un des principaux bénéfices est l’amélioration de la productivité. L’IA permet d’automatiser des tâches répétitives et à faible valeur ajoutée, ce qui libère du temps pour des missions plus stratégiques et créatives. Dans notre groupe, nous utilisons par exemple l’IA pour optimiser la gestion des stocks, ce qui réduit les coûts et améliore la réactivité face aux fluctuations de la demande.

Un autre avantage est l’amélioration de la prise de décision. Grâce à l’analyse des données en temps réel, nous pouvons anticiper les tendances du marché, ajuster nos stratégies et mieux répondre aux besoins des clients. Cela permet aussi d’avoir une approche plus agile et plus efficace.

Guillaume : Dans le secteur aéronautique, l’IA joue un rôle clé dans la sécurité et la maintenance prédictive. Nous pouvons détecter des anomalies sur un avion avant qu’elles ne deviennent critiques, ce qui réduit les incidents et améliore la sécurité des passagers. L’IA permet aussi de simuler des scénarios complexes, ce qui est un atout majeur pour la formation des pilotes et des ingénieurs.

- Coursel : Avant de conclure cette première table ronde, j’aimerais vous demander à chacun un mot sur la façon dont nous pouvons assurer une transition réussie vers un monde du travail intégré à l’IA.

Gilbert Fosser : La clé est l’inclusivité. Il ne faut laisser personne sur le bord de la route. Cela implique un effort collectif des gouvernements, des entreprises et des travailleurs pour mettre en place des solutions adaptées à chacun.

Christy Hoffman : La régulation et la transparence doivent être au cœur de cette transition. Nous devons nous assurer que l’IA est utilisée pour améliorer la vie des travailleurs, et non pour les surveiller ou les exploiter.

Denis Machel : L’éducation et la formation sont essentielles. Investir dans les compétences, c’est investir dans l’avenir.

Guillaume : Enfin, il faut garder une approche humaine. L’IA est un outil puissant, mais elle doit rester au service des humains, et non l’inverse.

- Coursel : Merci à tous pour cet échange riche et passionnant. Nous allons maintenant passer à la deuxième session de cette journée dédiée à l’IA et à l’innovation.

Table ronde : Créer un cercle vertueux entre l’IA, l’information et la création (Contenu généré et imaginé par ChatGPT)

Modérateur : Sophie Lemoine, journaliste spécialisée en technologies et médias

Intervenants

- Jean-Baptiste Roux, Directeur de l’innovation chez Mistral AI

- Dr. Ananya Kapoor, Conseillère au ministère indien du Numérique et de l’Intelligence Artificielle

Introduction du modérateur :

Bonjour à tous et merci d’être présents pour cette table ronde. Aujourd’hui, nous allons explorer comment l’IA peut favoriser un cercle vertueux entre information et création, tout en assurant un équilibre éthique et durable.

Première question : Comment l'IA transforme-t-elle la production et la diffusion de l'information ?

Jean-Baptiste Roux : L'IA joue déjà un rôle crucial dans l'automatisation de la collecte et de la diffusion de l'information. Chez Mistral AI, nous développons des modèles capables d'analyser rapidement de grandes quantités de données et de générer des résumés pertinents pour les journalistes. Toutefois, nous devons être vigilants à la vérification des faits et à la qualité des sources pour éviter la propagation de désinformation.

Dr. Ananya Kapoor : En Inde, nous mettons l'accent sur l'accessibilité de l'information grâce à l'IA. Les outils de traduction automatique permettent à des millions de citoyens d'accéder à des contenus qui étaient auparavant inaccessibles. Cependant, l’enjeu reste de garantir la transparence des algorithmes et de lutter contre les biais pour préserver la diversité et la pluralité des points de vue.

Deuxième question : Quel impact de l'IA sur la création artistique et intellectuelle ?

Jean-Baptiste Roux : L'IA est un formidable outil de créativité. De nombreux artistes utilisent des modèles d’IA pour enrichir leurs processus de création, en musique, en peinture ou en écriture. Mais il faut aussi garantir la reconnaissance et la rémunération des créateurs humains. Nous travaillons sur des solutions de traçabilité pour assurer un usage éthique des contenus générés.

Dr. Ananya Kapoor : Nous devons protéger la création humaine tout en exploitant les capacités de l'IA. Les gouvernements ont un rôle à jouer dans la régulation et la mise en place de normes pour éviter les abus. En Inde, nous testons un système de certification des contenus générés par IA pour mieux identifier leur origine.

Troisième question : Comment assurer un équilibre entre innovation et éthique dans l'utilisation de l'IA ?

Jean-Baptiste Roux : La solution repose sur une collaboration entre acteurs publics et privés. Il faut établir des standards internationaux pour encadrer l'utilisation de l'IA et garantir qu'elle bénéficie à tous. La transparence est essentielle : les utilisateurs doivent savoir comment et pourquoi un contenu leur est proposé.

Dr. Ananya Kapoor : L'éducation numérique est une priorité. Il est crucial de former les citoyens à comprendre les mécanismes de l'IA afin de développer un esprit critique face à l'information et à la création assistée par l'IA. En parallèle, les régulations doivent être adaptées pour protéger les droits des individus tout en stimulant l'innovation.

Conclusion du modérateur

L'IA offre des opportunités immenses pour le monde de l'information et de la création, mais son développement doit s'accompagner de régulations et d'une réflexion éthique approfondie. Un cercle vertueux est possible si nous restons attentifs aux impacts sur la société et impliquons toutes les parties prenantes. Merci à nos intervenants pour cet échange enrichissant !

Table ronde : Vie privée, cybersécurité et intégrité de l'information : tirer parti de l'IA pour protéger les démocraties (Contenu généré et imaginé par ChatGPT)

Modérateur : Nicolas Dupont, expert en cybersécurité et consultant pour l'UE

Intervenants

- Dr. Élise Martin, Directrice de la Cybersécurité chez Mistral AI

- Rajesh Patel, Secrétaire adjoint au ministère indien de la Technologie et de la Cybersécurité

Introduction du modérateur :

Bonsoir à tous et merci de nous rejoindre pour cette discussion essentielle. Alors que l'IA devient une force majeure dans nos sociétés, nous devons nous interroger sur son rôle dans la protection de la vie privée, de la cybersécurité et de l'intégrité de l'information. Comment les gouvernements et les entreprises peuvent-ils utiliser ces technologies tout en préservant les valeurs démocratiques ?

Première question : Comment l'IA peut-elle renforcer la cybersécurité face aux cybermenaces croissantes ?

Dr. Élise Martin : L'IA est déjà un outil clé pour identifier et répondre aux cyberattaques en temps réel. Chez Mistral AI, nous développons des systèmes capables de détecter des anomalies dans les flux de données, prédisant ainsi les menaces avant qu'elles ne se matérialisent. Cependant, il faut veiller à ce que ces outils soient transparents et respectueux de la vie privée.

Rajesh Patel : En Inde, nous avons déployé des solutions d'IA pour surveiller les attaques à grande échelle sur nos infrastructures critiques. Mais l'IA ne doit pas seulement être réactive : elle doit aussi aider à prévoir les menaces et à renforcer la résilience des systèmes numériques. Cela passe par une coopération internationale pour éviter les abus et les cyberattaques coordonnées.

Deuxième question : Quel rôle l'IA peut-elle jouer dans la protection de la vie privée ?

Dr. Élise Martin : L'IA peut, paradoxalement, être un rempart contre l'exploitation abusive des données personnelles. Par exemple, des techniques comme l'apprentissage fédéré permettent d'entraîner des modèles sans exposer de données sensibles. Mais il faut une régulation claire pour que ces technologies ne deviennent pas des outils de surveillance de masse.

Rajesh Patel : Nous travaillons sur des systèmes d'IA qui permettent aux citoyens de mieux contrôler leurs données. L'utilisation d'identités numériques décentralisées est une piste intéressante. En revanche, il est crucial de maintenir un équilibre entre protection de la vie privée et intérêts de sécurité nationale.

Troisième question : Comment l'IA peut-elle garantir l'intégrité de l'information face à la désinformation ?

Dr. Élise Martin : Nous avons vu une explosion des deepfakes et des contenus manipulés. L'IA peut nous aider à les détecter en analysant les métadonnées, les anomalies visuelles et les sources. Mais la lutte contre la désinformation n'est pas seulement technologique : elle doit inclure une éducation à l'esprit critique et des initiatives collaboratives entre médias, chercheurs et gouvernements.

Rajesh Patel : En Inde, nous avons lancé des programmes de vérification automatisée des faits, en utilisant l'IA pour repérer et signaler les fausses informations sur les réseaux sociaux. Toutefois, il faut veiller à ne pas instaurer de censure involontaire. La transparence des algorithmes est essentielle pour que la population ait confiance dans ces systèmes.

Conclusion du modérateur

Nous avons vu que l'IA peut être un atout majeur pour la protection des démocraties, mais qu'elle n'est pas une solution miracle. Elle doit être encadrée par des régulations fortes et une approche éthique rigoureuse. L'avenir de la cybersécurité et de la vie privée dépendra de la manière dont nous intégrons ces technologies tout en préservant nos valeurs fondamentales. Merci à nos intervenants et à notre audience pour cette discussion enrichissante.

Table ronde : Vers une gouvernance mondiale de l’IA efficiente, efficace et inclusive (Contenu généré et imaginé par ChatGPT)

Modérateur : Camille Durand, analyste en politiques technologiques internationales

Intervenants

- Prof. Laurent Besson, Conseiller pour la régulation de l’IA à la Commission européenne

- Dr. Priya Mehta, Représentante du Ministère indien du Numérique et de l’Intelligence Artificielle

Introduction du modérateur :

Bienvenue à cette table ronde consacrée à la gouvernance mondiale de l’IA. Avec des enjeux éthiques, économiques et sociétaux majeurs, la question est de savoir comment construire une régulation internationale qui soit à la fois efficace et inclusive. Nous allons explorer ensemble les pistes pour une collaboration équilibrée entre gouvernements, entreprises et société civile.

Première question : Quels sont les principaux défis d’une gouvernance mondiale de l’IA ?

Prof. Laurent Besson : L’un des grands défis est l’harmonisation des réglementations. L’Europe a adopté l’AI Act, qui impose des standards élevés en matière de transparence et de contrôle des risques. Toutefois, d’autres régions du monde adoptent des approches différentes, parfois plus permissives. Le défi est donc de concilier ces visions tout en garantissant une innovation responsable.

Dr. Priya Mehta : Du point de vue indien, nous devons nous assurer que la gouvernance mondiale de l’IA ne soit pas dominée par quelques grandes puissances technologiques. Il est essentiel d’inclure les pays émergents dans l'élaboration des normes et de prévoir des mécanismes pour aider ces pays à adopter des technologies IA sans créer de nouvelles fractures numériques.

Deuxième question : Quelles solutions pour une régulation inclusive et efficace ?

Prof. Laurent Besson : Une solution serait de créer un cadre international sous l’égide d’organisations comme l’ONU ou l’OCDE. Nous devons aussi encourager des partenariats entre gouvernements, entreprises et universités pour éviter qu’une seule entité ne dicte les règles du jeu.

Dr. Priya Mehta : En Inde, nous plaidons pour des plateformes de dialogue régulières entre les différents acteurs, y compris les ONG et les représentants de la société civile. Une approche participative est essentielle pour anticiper les impacts sociétaux de l’IA et garantir qu’elle bénéficie à tous.

Troisième question : Comment favoriser la coopération internationale sans freiner l’innovation ?

Prof. Laurent Besson : Il faut un équilibre entre flexibilité et régulation. Plutôt que des restrictions rigides, nous pouvons adopter des cadres adaptables selon les risques liés à chaque type d’IA. L’important est d’assurer une surveillance proportionnée tout en soutenant les PME et start-ups qui innovent dans ce domaine.

Dr. Priya Mehta : L’Inde propose des initiatives de coopération en matière de recherche et de développement, notamment en IA responsable. En favorisant le partage de bonnes pratiques et en créant des incitations pour des solutions éthiques, nous pouvons aligner croissance économique et protection des valeurs humaines.

Conclusion du modérateur

Nous avons vu que la gouvernance mondiale de l’IA repose sur un équilibre entre innovation, inclusion et régulation. Une approche collaborative est indispensable pour garantir que l’IA profite à tous sans creuser les inégalités. Merci à nos intervenants pour leurs perspectives enrichissantes et à vous pour votre participation active.

Table ronde : Faire grandir des écosystèmes d'IA compétitifs et soutenables dans le monde entier (Contenu généré et imaginé par ChatGPT)

Modérateur : Julien Lefevre, analyste en politiques publiques pour l'innovation technologique

Intervenants

- Dr. Sofia Almeida, Directrice de la stratégie IA chez Mistral AI

- Pr. Arun Dev, Conseiller spécial au Ministère indien des Technologies de l'Information

Introduction du modérateur :

Bienvenue à cette discussion sur le développement d'écosystèmes d'IA compétitifs et soutenables. L'intelligence artificielle transforme l'économie mondiale, et nous devons nous assurer que sa croissance soit à la fois dynamique et équilibrée. Comment favoriser l'innovation tout en garantissant un développement responsable et inclusif ?

Première question : Quels sont les principaux facteurs qui permettent de créer un écosystème IA compétitif ?

Dr. Sofia Almeida : Pour qu'un écosystème IA soit compétitif, il faut un investissement massif dans la recherche et le développement. L'Europe doit renforcer ses collaborations entre universités, startups et grandes entreprises pour maintenir une avance technologique. L'accès aux données et aux infrastructures de calcul est également déterminant.

Pr. Arun Dev : L'Inde mise sur la formation et l'accessibilité. Nous avons mis en place des programmes d'éducation en IA accessibles à tous, ce qui permet d'attirer des talents diversifiés. Un cadre réglementaire souple mais clair est aussi nécessaire pour que les entreprises puissent innover en toute confiance.

Deuxième question : Comment garantir que ces écosystèmes soient soutenables sur le long terme ?

Dr. Sofia Almeida : La soutenabilité repose sur l'efficacité énergétique et la gouvernance des modèles d'IA. Chez Mistral AI, nous travaillons sur des architectures plus sobres pour réduire l'empreinte carbone. De plus, il faut des incitations pour favoriser une IA éthique et responsable.

Pr. Arun Dev : Un écosystème IA soutenable doit être inclusif. Nous devons veiller à ce que les bénéfices de l'IA profitent à toutes les populations, y compris celles des pays en développement. Des partenariats internationaux peuvent aider à partager les meilleures pratiques et les ressources.

Troisième question : Quel rôle pour la coopération internationale ?

Dr. Sofia Almeida : La coopération est essentielle pour définir des standards communs et éviter une fragmentation réglementaire. Nous devons aussi mutualiser les efforts pour le développement d'IA de confiance, afin de garantir un cadre harmonieux pour l'innovation.

Pr. Arun Dev : L'Inde collabore déjà avec plusieurs pays sur des projets IA dans la santé et l'agriculture. Partager des solutions concrètes permet d'accélérer l'adoption et de garantir une IA bénéfique pour tous. Il faut aussi impliquer les organisations internationales pour structurer ces coopérations.

Conclusion du modérateur

Nous avons exploré les clés d'un écosystème IA compétitif et soutenable. Il est crucial de combiner innovation, inclusion et coopération pour que l'IA puisse réellement bénéficier à tous. Merci à nos intervenants pour ces éclairages passionnants.

Table ronde : Orienter l'IA vers l'intérêt général : vers un écosystème d'IA résilient et ouvert (Contenu généré et imaginé par ChatGPT)

Modérateur : Claire Dufresne, experte en éthique et régulation de l'IA

Intervenants

- Dr. Marc Legrand, Directeur de la recherche en IA chez Mistral AI

- Prof. Aisha Rao, Conseillère en innovation auprès du gouvernement indien

Introduction du modérateur :

Bienvenue à cette table ronde sur l'orientation de l'IA vers l'intérêt général. L'IA a le potentiel de transformer nos sociétés, mais comment garantir qu'elle soit développée et utilisée de manière ouverte, résiliente et bénéfique pour tous ?

Première question : Quels sont les principes clés d'une IA au service de l'intérêt général ?

Dr. Marc Legrand : Une IA au service de l'intérêt général repose sur trois piliers : transparence, accessibilité et impact social positif. Nous devons assurer que les modèles d'IA soient compréhensibles et auditables, tout en facilitant leur accès aux chercheurs et aux petites entreprises.

Prof. Aisha Rao : En Inde, nous avons mis en place des initiatives pour déployer l'IA dans des secteurs cruciaux comme la santé et l'éducation. Un cadre éthique fort et des mécanismes de responsabilisation sont essentiels pour éviter les dérives et maximiser l'impact positif.

Deuxième question : Comment rendre l'écosystème IA plus résilient face aux crises et aux défis globaux ?

Dr. Marc Legrand : Une IA résiliente doit être décentralisée et capable de fonctionner dans des contextes variés. L'utilisation de modèles open-source et de collaborations internationales peut aider à atténuer les risques de dépendance envers quelques acteurs dominants.

Prof. Aisha Rao : Nous devons encourager des infrastructures numériques robustes et adaptatives. En Inde, nous travaillons sur des plateformes locales de données ouvertes pour que les solutions IA puissent être développées et déployées à grande échelle sans barrières excessives.

Troisième question : Comment favoriser une IA ouverte et accessible sans compromettre la sécurité et la protection des données ?

Dr. Marc Legrand : L'ouverture ne doit pas signifier absence de contrôle. Nous pouvons garantir la protection des données en utilisant des techniques comme l'apprentissage fédéré et les modèles d'IA explicables. Un équilibre entre accès et sécurité est indispensable.

Prof. Aisha Rao : L'adoption de normes internationales pour la gouvernance des données et l'interopérabilité des systèmes IA peut créer un cadre fiable. La collaboration entre régulateurs, chercheurs et développeurs est essentielle pour assurer un développement harmonieux.

Conclusion du modérateur

Nous avons exploré les moyens de construire un écosystème d'IA résilient, ouvert et aligné sur l'intérêt général. Il est crucial de promouvoir l'innovation responsable tout en préservant l'équité et la transparence. Merci à nos intervenants pour ces échanges enrichissants.

Conférence : Construire une IA de confiance : des engagements volontaires à des codes de bonnes pratiques collaboratifs (Contenu généré et imaginé par ChatGPT)

Intervenant : Dr. Émilie Laurent, Directrice éthique et conformité chez Mistral AI

Introduction

Bonjour à toutes et à tous. La confiance dans l'intelligence artificielle est un enjeu crucial. Si nous voulons maximiser les bénéfices de l'IA tout en minimisant les risques, nous devons aller au-delà des simples engagements volontaires et structurer des codes de bonnes pratiques collaboratifs. Comment concilier innovation et régulation pour une IA responsable ? C’est la question à laquelle nous allons répondre aujourd’hui.

Les enjeux de la confiance en IA :

L’IA est aujourd’hui au cœur de nombreux secteurs : santé, finance, mobilité, mais elle suscite aussi des interrogations majeures :

- Comment garantir la transparence et l’explicabilité des systèmes d’IA ?

- Comment prévenir les biais algorithmiques et les discriminations ?

- Quel rôle pour la régulation face à une évolution technologique rapide ?

De l’engagement volontaire à la collaboration structurée :

Les entreprises technologiques ont commencé par adopter des engagements volontaires pour rassurer le public et les régulateurs. Cependant, ces engagements, bien que nécessaires, ne suffisent pas toujours. Nous observons une évolution vers des codes de bonnes pratiques élaborés en concertation avec les gouvernements, les chercheurs et la société civile.

Les piliers d’un code de bonnes pratiques collaboratif :

1. Transparence et auditabilité : publication des critères de décision des modèles.

2. Mécanismes de responsabilisation : mise en place de comités éthiques pour encadrer les usages sensibles.

3. Sécurité et protection des données : développement de normes strictes pour garantir la confidentialité.

4. Inclusion et accessibilité : assurer que l’IA bénéficie à l’ensemble de la société et ne renforce pas les inégalités.

5. Collaboration internationale : harmonisation des pratiques à l'échelle mondiale pour éviter des disparités trop grandes entre les pays.

Exemples de bonnes pratiques en cours :

- L’initiative de l’Union européenne avec l’AI Act.

- La charte d’éthique IA de l’UNESCO.

- Les initiatives des grandes entreprises technologiques qui commencent à ouvrir leurs modèles pour des audits indépendants.

Conclusion :

La construction d’une IA de confiance passe par une approche collaborative et proactive. Il ne s’agit pas d’opposer innovation et régulation, mais de les articuler de manière intelligente pour que l’IA serve les intérêts de tous. En travaillant ensemble, nous pouvons développer des systèmes d’IA qui soient à la fois performants, éthiques et sécurisés.

Merci pour votre attention.

Table ronde : Vers une IA sûre et de confiance : le code de pratiques collaboratif de l’UE (Contenu généré et imaginé par ChatGPT)

Modérateur : Anne Leclerc, experte en régulation technologique

Intervenants

- Dr. François Dubois, Responsable de l’IA responsable à la Commission européenne

- Dr. Rajiv Sharma, Spécialiste en éthique et gouvernance de l’IA en Inde

Introduction du modérateur :

Bienvenue à cette table ronde sur l'initiative européenne pour une IA sûre et de confiance. Aujourd'hui, nous allons explorer comment l'UE structure son code de pratiques collaboratif et quel impact il peut avoir sur le développement de l'IA à l'échelle mondiale.

Première question : Quels sont les objectifs principaux du code de pratiques collaboratif de l'UE ?

Dr. François Dubois : L'UE a développé ce code pour garantir que l'IA soit transparente, éthique et respectueuse des droits fondamentaux. Il repose sur des principes clés comme l'explicabilité des modèles, la non-discrimination et la sécurité des systèmes. L'objectif est d'instaurer une confiance durable entre les citoyens et les technologies d'IA.

Dr. Rajiv Sharma : L'initiative européenne est une référence pour de nombreux pays. En Inde, nous nous inspirons de cette approche pour développer nos propres standards éthiques. Le dialogue international est essentiel pour éviter une fragmentation des régulations.

Deuxième question : Comment ce code de pratiques impacte-t-il les entreprises et les développeurs ?

Dr. François Dubois : Les entreprises doivent adapter leurs processus de développement pour intégrer des évaluations éthiques et des audits de sécurité. Cela représente un coût initial, mais à long terme, cela crée un avantage compétitif en renforçant la confiance des utilisateurs et en évitant des risques juridiques.

Dr. Rajiv Sharma : Il est important que ces obligations ne deviennent pas un frein à l'innovation. Un équilibre doit être trouvé entre régulation et flexibilité, notamment pour les start-ups qui ont moins de ressources pour se conformer à des règles complexes.

Troisième question : Quels sont les défis pour une adoption mondiale d’un cadre éthique commun ?

Dr. François Dubois : Le principal défi est l'harmonisation des standards entre les grandes régions du monde. Chaque pays a ses propres priorités et traditions juridiques. Un dialogue constant est nécessaire pour éviter des conflits réglementaires et permettre une interopérabilité des solutions IA.

Dr. Rajiv Sharma : L’implication des pays en développement est cruciale. Si seuls les grands acteurs économiques participent à l'élaboration des normes, nous risquons de créer une fracture technologique. Des coopérations doivent être mises en place pour favoriser un accès équitable aux meilleures pratiques.

Conclusion du modérateur

Le code de pratiques collaboratif de l’UE est une étape majeure vers une IA plus sûre et éthique. Son adoption à l'échelle mondiale demandera des efforts de coordination et de dialogue. Merci à nos intervenants pour ces échanges enrichissants.

Table ronde : Favoriser l'innovation en matière d’IA par la collaboration entre l'industrie et les pouvoirs publics (Contenu généré et imaginé par ChatGPT)

Modérateur : Pierre Lambert, consultant en politiques publiques pour l'innovation technologique

Intervenants

- Dr. Isabelle Moreau, Directrice de l'innovation chez Mistral AI

- Pr. Ravi Gupta, Conseiller scientifique au Ministère indien des Technologies de l'Information

Introduction du modérateur :

Bienvenue à cette table ronde consacrée à la collaboration entre l'industrie et les pouvoirs publics pour favoriser l'innovation en IA. Cette synergie est essentielle pour accélérer les progrès technologiques tout en garantissant un développement éthique et bénéfique pour la société.

Première question : Quels sont les principaux leviers permettant une collaboration efficace entre les entreprises et les gouvernements ?

Dr. Isabelle Moreau : Un des leviers essentiels est le cofinancement de la recherche et développement. Les gouvernements peuvent stimuler l'innovation en mettant en place des incitations fiscales et des fonds d'investissement pour les start-ups IA. Il est également crucial d'établir des cadres de travail communs entre le public et le privé pour aligner les objectifs et maximiser l'impact des nouvelles technologies.

Pr. Ravi Gupta : En Inde, nous avons mis en place des plateformes de collaboration où les chercheurs académiques et les entreprises technologiques peuvent échanger sur leurs avancées. L'un des enjeux est de garantir l'accès aux infrastructures de calcul et aux bases de données publiques, afin que l'innovation ne soit pas freinée par un manque de ressources.

Deuxième question : Quels sont les défis à surmonter pour créer un écosystème IA dynamique et durable ?

Dr. Isabelle Moreau : L'un des principaux défis est la réglementation. Une régulation trop stricte peut freiner l'innovation, tandis qu'un manque de cadre peut entraîner des abus. L'idéal est de co-construire des règles flexibles, adaptées aux différentes applications de l'IA. Nous avons également besoin d'une normalisation des protocoles d'intelligence artificielle pour assurer l'interopérabilité des systèmes.

Pr. Ravi Gupta : La formation et le développement des compétences sont des priorités. Sans une main-d'œuvre qualifiée, même les meilleures politiques de soutien à l'IA ne seront pas suffisantes. En Inde, nous avons investi massivement dans des programmes d'apprentissage numérique pour préparer la prochaine génération d'experts IA.

Troisième question : Comment assurer que l'innovation en IA bénéficie à l'ensemble de la société ?

Dr. Isabelle Moreau : Nous devons veiller à ce que l'IA ne creuse pas les inégalités sociales. L'inclusion doit être une priorité, avec des politiques qui facilitent l'accès aux technologies pour les PME et les secteurs non technologiques. Des initiatives de transparence et d'explicabilité des systèmes IA sont aussi essentielles pour garantir leur acceptabilité sociétale.

Pr. Ravi Gupta : En Inde, nous avons mis en place des projets d'IA appliqués à la santé et à l'agriculture afin d'améliorer la qualité de vie des populations rurales. Une IA qui sert l'intérêt général doit être adaptée aux réalités locales et développée en concertation avec les communautés concernées.

Conclusion du modérateur

Cette discussion a mis en lumière les opportunités et les défis d'une collaboration entre l'industrie et les pouvoirs publics dans le domaine de l'IA. Il est indispensable de poursuivre ces efforts pour créer un écosystème innovant, inclusif et résilient. Merci à nos intervenants pour leurs contributions enrichissantes.

Table ronde : Face au mur des données scientifiques (Contenu généré et imaginé par ChatGPT)

Modérateur : Nathalie Dupont, journaliste scientifique

Intervenants

- Dr. Alain Morel, Directeur de recherche en intelligence artificielle appliquée aux sciences

- Pr. Meera Khanna, Spécialiste en gestion des données au Centre National de Recherche Indien

Introduction du modérateur :

Bienvenue à cette table ronde consacrée aux défis posés par l'explosion des données scientifiques. Avec l'essor de l'IA et des capacités de calcul, les chercheurs sont confrontés à un volume exponentiel d'informations. Comment organiser, stocker et exploiter ces données de manière efficiente et éthique ?

Première question : Quels sont les principaux défis posés par la masse croissante des données scientifiques ?

Dr. Alain Morel : L'un des problèmes majeurs est la fragmentation des bases de données. De nombreux travaux scientifiques sont publiés dans des formats incompatibles ou stockés sur des plateformes dispersées, ce qui complique leur exploitation. Nous avons besoin d'interopérabilité et de standards communs.

Pr. Meera Khanna : En Inde, nous avons mis en place des infrastructures de stockage décentralisées pour garantir un accès plus large aux données scientifiques. Cependant, le volume des données est tel que même ces solutions atteignent leurs limites. La question de l'efficacité du stockage et de la gestion des données reste cruciale.

Deuxième question : Comment l'IA peut-elle aider à surmonter ces obstacles ?

Dr. Alain Morel : L'IA joue un rôle clé en facilitant l'indexation, la classification et l'analyse des données. Les modèles d'apprentissage automatique permettent de détecter des tendances et d'automatiser le tri des informations utiles, mais cela nécessite une rigueur éthique pour éviter les biais et garantir la fiabilité des résultats.

Pr. Meera Khanna : Nous travaillons à l'intégration de systèmes d'IA capables de croiser des données issues de sources diverses tout en respectant la confidentialité et la propriété intellectuelle des chercheurs. L'enjeu est de trouver un équilibre entre accessibilité et protection des informations.

Troisième question : Quelles solutions pour garantir une gestion durable et éthique des données scientifiques ?

Dr. Alain Morel : La mise en place de politiques ouvertes, comme le mouvement FAIR (Findable, Accessible, Interoperable, Reusable), est essentielle. Il faut aussi renforcer les collaborations internationales pour développer des infrastructures partagées et promouvoir une science plus transparente.

Pr. Meera Khanna : La formation des chercheurs à la gestion des données est primordiale. Nous devons également nous assurer que les outils de l'IA ne créent pas de nouvelles inégalités d'accès à l'information. L'harmonisation des règles de gouvernance des données est un pas dans la bonne direction.

Conclusion du modérateur

Cette discussion a mis en lumière la complexité de la gestion des données scientifiques et les solutions possibles pour surmonter ces défis. Une approche collaborative, intégrant l'IA de manière éthique, semble être la clé d'une science plus accessible et efficace. Merci à nos intervenants pour leurs perspectives enrichissantes.

Atelier : Gouvernance internationale de l'IA (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Sophie Renaud, experte en politiques technologiques internationales

Introduction

Bienvenue à cet atelier sur la gouvernance internationale de l'intelligence artificielle. Alors que l'IA se développe à un rythme exponentiel, la coopération entre nations, entreprises et société civile devient essentielle pour en garantir une utilisation éthique et responsable.

Objectifs de l'atelier

- Comprendre les enjeux de la gouvernance mondiale de l'IA

- Identifier les différents modèles de régulation existants

- Discuter des initiatives actuelles et futures pour une IA sûre et inclusive

- Proposer des recommandations pour une coopération efficace

Première partie : Les enjeux d'une gouvernance mondiale de l'IA

- Fragmentation des régulations et risques d'incompatibilité

- Déséquilibres entre pays en développement et pays industrialisés

- Protection des données et respect des libertés fondamentales

Deuxième partie : Présentation des modèles existants

- Approche de l'Union européenne avec l'AI Act

- Stratégies des États-Unis et de la Chine en matière de régulation

- Cadres de coopération multilatérale : OCDE, ONU, G7 et autres initiatives

Troisième partie : Vers une coopération internationale efficace

- Harmonisation des standards et certifications communes

- Rôle des entreprises et des acteurs non gouvernementaux

- Mécanismes de gouvernance participative et inclusifs

Conclusion et recommandations

L'atelier se conclura par une séance interactive où les participants seront invités à partager leurs idées et suggestions pour une gouvernance internationale plus efficace et adaptée aux enjeux de demain.

Merci pour votre participation !

Atelier : L'IA dans la santé : Identifier les opportunités dans les marchés mal desservis, prioriser des preuves empiriques (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Claire Fontaine, experte en IA et santé publique

Introduction

Bienvenue à cet atelier consacré à l'utilisation de l'intelligence artificielle pour améliorer l'accès aux soins dans les marchés mal desservis. L'objectif est d'identifier les opportunités offertes par l'IA et d'explorer comment les décisions peuvent être guidées par des preuves empiriques.

Objectifs de l'atelier

- Comprendre les défis des systèmes de santé dans les marchés mal desservis

- Identifier les solutions basées sur l'IA pour réduire ces inégalités

- Discuter de l'importance des données et des preuves empiriques pour garantir l'efficacité des interventions

Première partie : Défis et opportunités de l'IA en santé

- Accès limité aux soins et pénurie de professionnels de santé

- Diagnostic et suivi des maladies via l'IA

- Automatisation des processus administratifs pour améliorer l'efficacité

Deuxième partie : La nécessité de preuves empiriques

- Collecte et analyse des données de santé

- Validation des algorithmes et réduction des biais

- Adoption et acceptabilité des solutions IA par les professionnels et patients

Troisième partie : Stratégies pour une implémentation efficace

- Partenariats entre secteurs public et privé

- Régulations et standards éthiques

- Formation et sensibilisation des acteurs de la santé

Conclusion et recommandations

L'atelier se terminera par une discussion ouverte pour recueillir des idées et recommandations afin de maximiser l'impact de l'IA sur les marchés mal desservis.

Merci pour votre participation !

Atelier : Comment réussir l'intégration de l'IA sur le lieu de travail (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Thomas Leclerc, expert en transformation numérique et intelligence artificielle

Introduction

Bienvenue à cet atelier consacré à l'intégration efficace de l'intelligence artificielle dans le milieu professionnel. L'IA transforme les modes de travail et offre de nouvelles opportunités, mais son adoption réussie repose sur une stratégie bien définie et une implication des parties prenantes.

Objectifs de l'atelier

- Identifier les bénéfices et défis de l'IA en entreprise

- Définir les meilleures pratiques pour une adoption efficace

- Explorer les impacts sur les compétences et l'organisation du travail

Première partie : Comprendre l'impact de l'IA sur le travail

- Automatisation des tâches et collaboration humain-machine

- Transformation des processus et gain en efficacité

- Répercussions sur les compétences et l'emploi

Deuxième partie : Stratégies pour une intégration réussie

- Implication des employés et accompagnement au changement

- Formation et développement des compétences

- Gouvernance et éthique de l’IA en entreprise

Troisième partie : Retours d’expérience et bonnes pratiques

- Exemples de mise en œuvre réussie

- Obstacles rencontrés et solutions apportées

- Perspectives et tendances

Conclusion et recommandations

L'atelier se terminera par une discussion ouverte pour partager les idées et recommandations permettant d'assurer une transition harmonieuse vers un environnement de travail augmenté par l'IA.

Merci pour votre participation !

Atelier : IA & Développement des enfants : un dialogue multipartite (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Léa Martin, experte en IA et éducation

Introduction

Bienvenue à cet atelier consacré à l'impact de l'intelligence artificielle sur le développement des enfants. L’IA est de plus en plus présente dans l’éducation et le quotidien des jeunes générations, soulevant à la fois des opportunités et des défis.

Objectifs de l'atelier

- Explorer les effets de l’IA sur l’apprentissage et le développement cognitif

- Identifier les risques et bénéfices des outils IA pour les enfants

- Encourager un dialogue entre chercheurs, éducateurs, parents et décideurs politiques

Première partie : Comprendre l’impact de l’IA sur l’éducation et le développement

- IA et personnalisation de l’apprentissage

- Développement des compétences cognitives et socio-émotionnelles

- Risques liés à la surexposition et à la dépendance aux technologies

Deuxième partie : Régulation et éthique de l’IA pour les enfants

- Protection des données et respect de la vie privée

- Éviter les biais algorithmiques dans les contenus éducatifs

- Rôle des parents et enseignants dans l’encadrement des outils IA

Troisième partie : Vers une adoption responsable et inclusive

- Exemples de bonnes pratiques et initiatives réussies

- Collaborations entre institutions éducatives, entreprises et pouvoirs publics

- Recommandations pour un usage équilibré de l’IA chez les enfants

Conclusion et recommandations

L'atelier se terminera par une discussion ouverte afin de formuler des recommandations concrètes pour une utilisation bénéfique et éthique de l'IA dans le développement des enfants.

Merci pour votre participation !

Atelier : ROOST : construire un futur open source pour la sécurité en ligne et la sécurité des IA (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Julien Perrin, expert en cybersécurité et intelligence artificielle

Introduction

Bienvenue à cet atelier dédié au projet ROOST, une initiative visant à promouvoir un écosystème open source pour renforcer la sécurité en ligne et celle des systèmes d’IA. Alors que les cybermenaces évoluent rapidement, l’open source offre une approche collaborative et transparente pour relever ces défis.

Objectifs de l'atelier

- Présenter l’initiative ROOST et son impact potentiel

- Explorer les avantages de l’open source en matière de cybersécurité et d’IA

- Identifier les défis et les solutions pour une adoption efficace

Première partie : L’importance de l’open source pour la sécurité numérique

- Transparence et auditabilité des systèmes de cybersécurité

- Collaboration et partage des connaissances

- Exemples d’initiatives open source réussies en cybersécurité et IA

Deuxième partie : ROOST et ses contributions à la sécurité des IA

- Détection et atténuation des attaques adversariales

- Protection des données et respect de la vie privée

- Développement de protocoles de sécurité ouverts et accessibles

Troisième partie : Vers une adoption large et durable de l’open source en cybersécurité

- Implication des gouvernements et des entreprises

- Formation et développement des compétences en sécurité open source

- Meilleures pratiques et recommandations pour un futur sécurisé

Conclusion et recommandations

L'atelier se conclura par une discussion interactive afin d’élaborer des pistes concrètes pour favoriser l’adoption de l’open source en cybersécurité et IA.

Merci pour votre participation !

Atelier : Diversité linguistique : allier valeurs et inclusion pour la diffusion de l’IA (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Amélie Bertrand, spécialiste en IA et inclusion linguistique

Introduction

Bienvenue à cet atelier dédié à la diversité linguistique et son importance dans le développement et la diffusion de l’intelligence artificielle. Alors que l’IA joue un rôle central dans la communication et l’accès à l’information, il est crucial d’intégrer toutes les langues et cultures pour garantir une inclusion véritable.

Objectifs de l'atelier

- Comprendre les enjeux de la diversité linguistique en IA

- Explorer des stratégies pour une meilleure représentation des langues minoritaires

- Identifier les défis et solutions pour un développement inclusif

Première partie : Pourquoi la diversité linguistique est essentielle en IA ?

- L’impact des biais linguistiques sur les modèles d’IA

- Accessibilité et inclusion dans les services numériques

- Études de cas : réussites et lacunes actuelles

Deuxième partie : Stratégies pour une IA linguistiquement inclusive

- Collecte et traitement de données multilingues

- Collaboration entre chercheurs, entreprises et institutions publiques

- Développement d’outils open source pour les langues sous-représentées

Troisième partie : Vers une gouvernance responsable et équitable

- Régulation et standards internationaux pour l’IA linguistique

- Implication des communautés locales dans l’annotation et l’évaluation des modèles

- Sensibilisation et formation des acteurs du numérique

Conclusion et recommandations

L'atelier se terminera par une discussion ouverte afin de proposer des pistes concrètes pour assurer une diffusion équitable et inclusive de l’IA à travers les différentes langues du monde.

Merci pour votre participation !

Atelier : Un appel à repenser l'IA : pourquoi les droits des femmes et des hommes importent plus que jamais (Contenu généré et imaginé par ChatGPT)

Animateur : Dr. Camille Durand, experte en éthique et IA inclusive

Introduction

Bienvenue à cet atelier dédié à l’impact de l’intelligence artificielle sur l’égalité des sexes et les droits fondamentaux. Alors que l’IA façonne nos sociétés, il est essentiel de s’assurer qu’elle ne perpétue ni n’amplifie les inégalités existantes.

Objectifs de l'atelier

- Identifier les biais de genre dans les systèmes d’IA

- Proposer des stratégies pour une IA plus équitable et inclusive

- Sensibiliser les acteurs de l’IA à l’importance des droits fondamentaux

Première partie : Comprendre les biais de genre en IA

- Études de cas : IA et discrimination genrée

- Origines des biais : données, algorithmes et conception

- Conséquences sur les opportunités professionnelles, la représentation sociale et l’accès aux services

Deuxième partie : Vers une IA équitable et inclusive

- Bonnes pratiques pour des modèles d’IA plus justes

- Rôle des entreprises et des décideurs publics

- Importance de la diversité dans les équipes de développement

Troisième partie : Actions concrètes et recommandations

- Régulations et cadres éthiques internationaux

- Implication des organisations de défense des droits humains

- Sensibilisation et formation des développeurs et utilisateurs

Conclusion et recommandations

L'atelier se conclura par une discussion ouverte afin de proposer des mesures concrètes pour faire de l’IA un levier de progrès et d’égalité.

Merci pour votre participation !