Coût du transfert learning sur un modèle Open Source comme Mixtral 8X 7B

Vous voulez développer une solution d’IA générative souveraine pour entreprise. Exit donc Azure, OpenAI Google ou Anthropic.

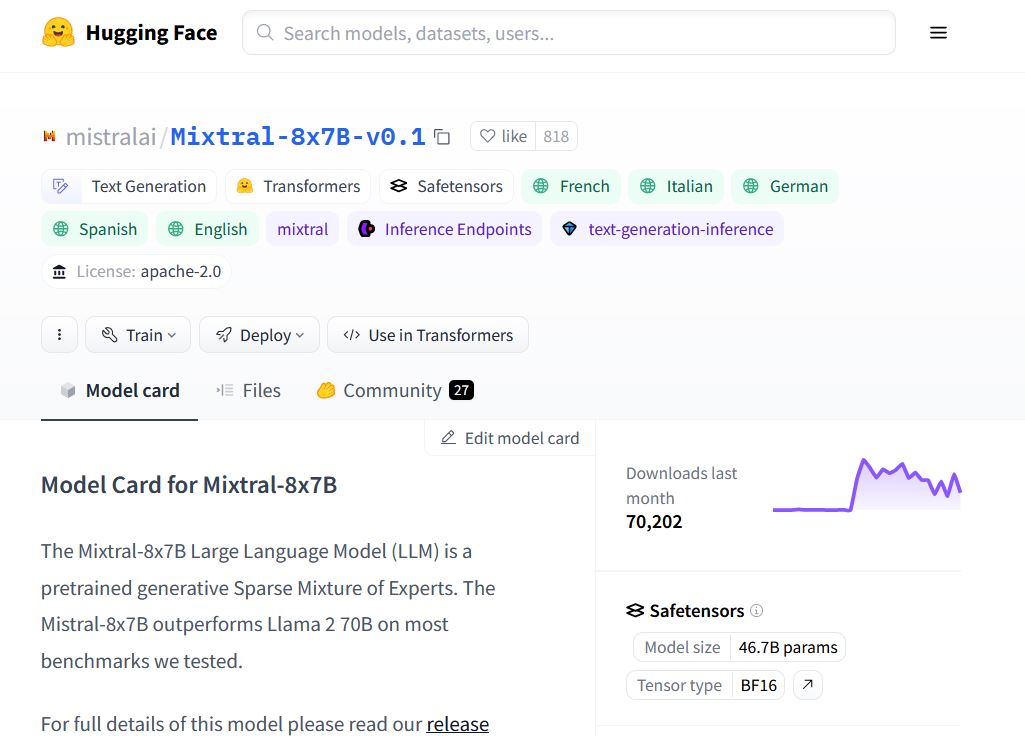

Vous envisagez, donc, de fine-tuner ou de faire du transfert learning par exemple sur le dernier modèle Open Source Mixtral 8X7B. Mais combien cela coûte-t-il ?

J’ai eu la chance d’échanger avec Didier Gaultier, « Head of Datascience & Ethics AI » sur les activités d’IA d’Orange Business France, qui est aussi directeur pédagogique d’une école de l’IA.

Au cours de la conversation, il a attiré mon attention sur le coût de l'open source.

De nombreuses entreprises souhaitent développer des technologies qui s’appuient sur des modèles d’IA générative.

Actuellement, la majorité se dirigent vers OpenAI, MS Azure, Google, AWS ou Anthropic autant pour les performances techniques, que parce que tout est packagé et prêt à l’usage : on crée un compte sur l’API, on apprend à requêter l’API avec la documentation en ligne et on peut lancer ses premiers tests.

On peut faire du RAG (Retrieval Augmented Generation) en utilisant ces modèles, en envoyant de sa propre documentation via l’API.

Problème : toutes ces données sont envoyées aux USA, voir plus loin.

#Souveraineté #Confidentialité

Certaines entreprises étudient, donc, les LLMs Open Source, dont, j’ai maintes fois parlés.

Pour ce faire :

- Elles choisissent un modèle Open Source, autorisant les usages commerciaux

- Elles installent le modèle sur leurs serveurs

- Elles personnalisent le modèle grâce au transfert learning

- Elles obtiennent un modèle entièrement sur mesure, un LLM unique

Cela semble fantastique puisque l’on peut ainsi obtenir son propre LLM, sans avoir besoin d’entraîner un modèle ex-nihilo tout en restant indépendant des grands acteurs américains, puisque l’on repart d’un modèle open source « gratuit ».

Enfin, presque, puisqu’il faut créer ce que Didier Gaultier qualifie une « landing zone » adaptée :

- des machines pour faire tourner le LLM,

- des cartes graphiques, de la mémoire et de l’espace disque SSD.

Pour « personnaliser » Mixtral 8X7B , il faut:

- Un ordinateur très puissant doté de plusieurs centaines de Go de RAM

- Des dizaines de cartes graphiques Nvidia H100 (qu’il faut commander lonnnngtemps à l’avance) : 350 000€ uniquement pour ces cartes

- 5 To de SSD pour stocker les poids

- Une très puissante alimentation électrique.

Alternative : installer Mixtral sur un cloud privé SecNumCloud, mais rien qu’en électricité, il est vraissemblabe qu’il faudra compter plusieurs dizaines d’euro par heure d’utilisation et plusieurs semaines pour entrainer le modèle…. une seule fois.

Car il est plus que probable que le 1er essai ne produira pas un modèle suffisamment performant et qu’il faudra réaliser un 2ème et un 3ème entraînement, aussi coûteux que le premier.

Et il manque encore une ligne de coût : le spécialiste, dont on a besoin de la compétence en entraînement de modèles.