La page que vous recherchez a du changé d'adresse.

Mais pas de panique, retrouvez tous nos contenus avec ce moteur de recherche

30 Formations à l'Intelligence Artificielle, au Marketing Digital et à l'Ecommerce pour 166€/mois

Révolution: faites former tous vos collaborateurs par un expert pour un tout petit forfait mensuel.

Formation IA pour l'éducation

Parcours pour les enseignants

Formation Midjourney

Cours accéléré pour débutants.

Formation Linkedin Ads

Cours pour débutants.

Formation Twitter Ads

Cours pour débutants.

Formation Tik Tok Ads

Cours pour débutants

Formation Création de site web No code avec Wordpress, Joomla ou Wix

Cours sans jargon et accessible.

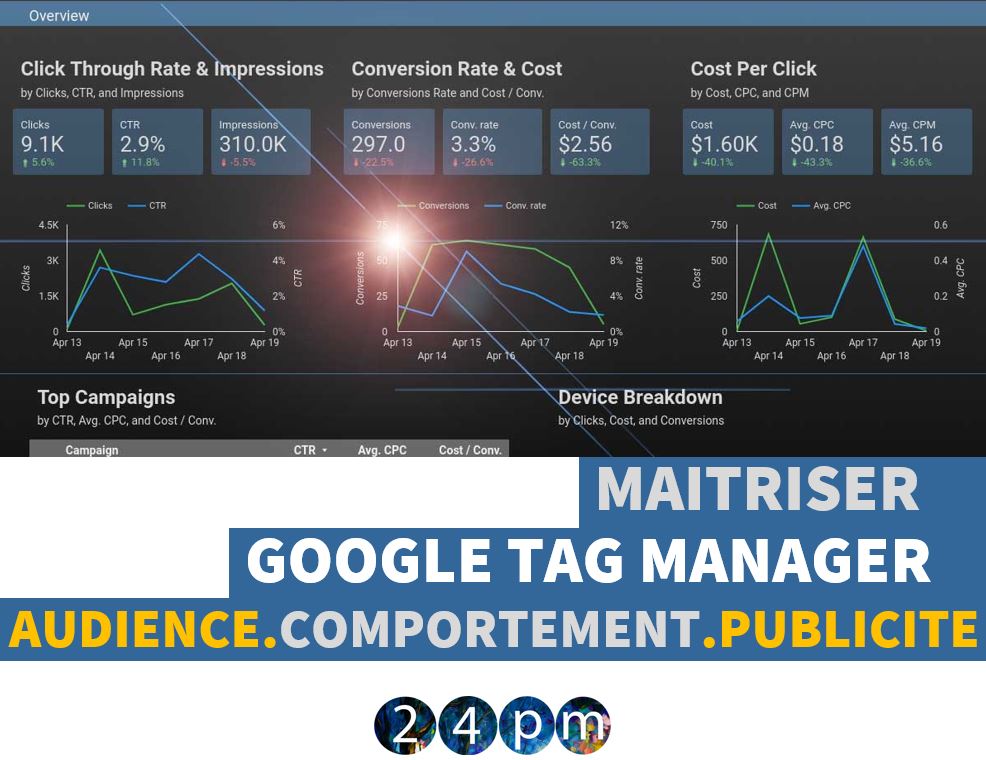

Formation Google Analytics 4 en ligne, 100% elearning

Cours simple et opérationnel

Formation référencement avec la méthode 100% SEO

Comment exploiter 100% de votre potentiel...

Formation: Lancer un ecommerce Anti Amazon en 24h

Une méthode efficace en 5 étapes

Formation Machine Learning / Deep Learning

Application, fonctionnement, technologie...

30 Formations

Intelligence Artificielle

Marketing Digital

Ecommerce

Forfait illimité: 166€/mois

Accès 100 collaborateurs

OF N°11756628075 - 17 rue etex, Paris